OpenAI a dévoilé son dernier modèle d'IA en langage large, o3-mini, qui est plus rapide et plus performant que son prédécesseur o1-mini pour fournir des réponses précises. Ce modèle est le premier petit modèle de raisonnement LLM de l'entreprise, disponible dès aujourd'hui pour une utilisation publique gratuite par tous les détenteurs d'un compte ChatGPT.

Le modèle o3-mini peut être exécuté en utilisant trois niveaux d'effort de raisonnement - faible, moyen et élevé. Toute personne disposant d'un compte ChatGPT gratuit peut exécuter o3-mini gratuitement au niveau de raisonnement moyen, tandis que les détenteurs d'un compte payant peuvent choisir les niveaux de raisonnement faible ou élevé. Les utilisateurs payants de ChatGPT Plus, Team et Pro ont un accès immédiat à o3-mini dès aujourd'hui, tandis que les utilisateurs Enterprise doivent attendre jusqu'en février. Les programmeurs désireux de créer des applications qui cartonnent grâce à l'API OpenAI o3-mini peuvent lire comment le faire avec ce livre sur Amazon.

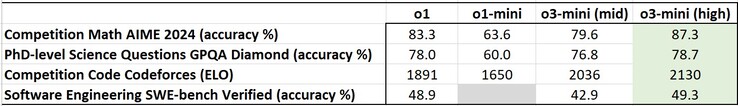

En général, o3-mini en mode de raisonnement moyen ou élevé surpasse o1-mini dans les tests d'IA standardisés, y compris ceux qui demandent à l'IA de raisonner à travers les problèmes. Lorsqu'il est réglé sur le mode de raisonnement élevé, o3-mini parvient également à surpasser le modèle plus grand o1 sur certains benchmarks, mais il n'a pas la capacité de o1 à voir les images et à traiter les données visuelles.

En particulier, o3-mini fournit des réponses 24 % plus rapidement que o1-mini, soit environ 2,46 secondes. Cela permet de réduire le temps d'attente des réponses de ChatGPT et les émissions de carbone produites par les ordinateurs utilisant o3-mini. Bien que plus rapide, o3-mini décevra les pirates informatiques car sa capacité à être utilisée pour des attaques de cybersécurité a été considérablement réduite.

31 janvier 2025

OpenAI o3-mini

Repousser les limites du raisonnement rentable.

Nous lançons OpenAI o3-mini, le modèle le plus récent et le plus rentable de notre série de raisonnement, disponible aujourd'hui à la fois dans ChatGPT et dans l'API. Prévu pour décembre 2024, ce modèle puissant et rapide repousse les limites de ce que les petits modèles peuvent réaliser, offrant des capacités STEM exceptionnelles - avec une force particulière en sciences, en mathématiques et en codage - tout en maintenant le faible coût et la latence réduite de l'OpenAI o1-mini.

OpenAI o3-mini est notre premier petit modèle de raisonnement qui prend en charge les fonctionnalités très demandées par les développeurs, notamment l'appel de fonction(s'ouvre dans une nouvelle fenêtre), les sorties structurées(s'ouvre dans une nouvelle fenêtre) et les messages de développeur(s'ouvre dans une nouvelle fenêtre), ce qui le rend prêt pour la production dès le départ. Comme OpenAI o1-mini et OpenAI o1-preview, o3-mini supportera le streaming(ouvre une nouvelle fenêtre). En outre, les développeurs peuvent choisir entre trois options d'effort de raisonnement(s'ouvre dans une nouvelle fenêtre) - faible, moyen et élevé - afin d'optimiser leurs cas d'utilisation spécifiques. Cette flexibilité permet à o3-mini de "penser plus fort" lorsqu'il s'agit de relever des défis complexes ou de donner la priorité à la vitesse lorsque la latence est un problème. o3-mini ne prend pas en charge les capacités de vision, les développeurs doivent donc continuer à utiliser OpenAI o1 pour les tâches de raisonnement visuel. o3-mini est déployé dans l'API Chat Completions, l'API Assistants et l'API Batch à partir d'aujourd'hui pour les développeurs sélectionnés dans les niveaux 3 à 5 d'utilisation de l'API(s'ouvre dans une nouvelle fenêtre).

Les utilisateurs de ChatGPT Plus, Team et Pro peuvent accéder à OpenAI o3-mini dès aujourd'hui, l'accès Enterprise étant prévu pour février. o3-mini remplacera OpenAI o1-mini dans le sélecteur de modèle, offrant des limites de taux plus élevées et une latence plus faible, ce qui en fait un choix convaincant pour les tâches de codage, de STIM et de résolution de problèmes logiques. Dans le cadre de cette mise à jour, nous triplons la limite de débit pour les utilisateurs Plus et Team, qui passe de 50 messages par jour avec o1-mini à 150 messages par jour avec o3-mini. En outre, o3-mini fonctionne désormais avec la recherche pour trouver des réponses actualisées avec des liens vers des sources web pertinentes. Il s'agit d'un premier prototype, car nous travaillons à l'intégration de la recherche dans nos modèles de raisonnement.

À partir d'aujourd'hui, les utilisateurs du plan gratuit peuvent également essayer OpenAI o3-mini en sélectionnant " Raisonner " dans le compositeur de messages ou en régénérant une réponse. C'est la première fois qu'un modèle de raisonnement est mis à la disposition des utilisateurs gratuits de ChatGPT.

Alors que OpenAI o1 reste notre modèle de raisonnement de connaissances générales, OpenAI o3-mini fournit une alternative spécialisée pour les domaines techniques nécessitant précision et rapidité. Dans ChatGPT, o3-mini utilise un effort de raisonnement moyen pour fournir un compromis équilibré entre vitesse et précision. Tous les utilisateurs payants auront également la possibilité de sélectionner o3-mini-high dans le sélecteur de modèle pour une version d'intelligence supérieure qui prend un peu plus de temps pour générer des réponses. Les utilisateurs professionnels auront un accès illimité à o3-mini et o3-mini-high.

Rapide, puissant et optimisé pour le raisonnement STEM

Tout comme son prédécesseur OpenAI o1, OpenAI o3-mini a été optimisé pour le raisonnement STEM. o3-mini avec un effort de raisonnement moyen correspond aux performances de o1 en mathématiques, codage et sciences, tout en fournissant des réponses plus rapides. Les évaluations des testeurs experts ont montré que o3-mini produit des réponses plus précises et plus claires, avec des capacités de raisonnement plus fortes, que l'OpenAI o1-mini. Les testeurs ont préféré les réponses de o3-mini à celles de o1-mini dans 56 % des cas et ont observé une réduction de 39 % des erreurs majeures sur des questions difficiles du monde réel. Avec un effort de raisonnement moyen, o3-mini égale les performances de o1 sur certaines des évaluations de raisonnement et d'intelligence les plus difficiles, y compris AIME et GPQA.

Concours de mathématiques (AIME 2024)

Le diagramme à barres compare la précision des modèles d'IA sur les questions de mathématiques du concours AIME 2024. Les anciens modèles (en gris) obtiennent de moins bons résultats, tandis que les nouveaux (en jaune) s'améliorent. "o3-mini (high)" atteint la précision la plus élevée avec 83,6 %, ce qui montre des progrès significatifs.

Mathématiques : Avec un faible effort de raisonnement, l'OpenAI o3-mini atteint des performances comparables à celles de l'OpenAI o1-mini, tandis qu'avec un effort moyen, o3-mini atteint des performances comparables à celles de o1. En revanche, avec un effort de raisonnement élevé, o3-mini surpasse à la fois OpenAI o1-mini et OpenAI o1, où les régions grisées montrent la performance du vote majoritaire (consensus) avec 64 échantillons.

Questions scientifiques de niveau doctoral (GPQA Diamond)

Le diagramme à barres compare la précision des modèles d'IA pour les questions scientifiques de niveau doctoral (GPQA Diamond). Les anciens modèles (en gris) obtiennent de moins bons résultats, tandis que les nouveaux (en jaune) s'améliorent. le modèle "o3-mini (high)" atteint une précision de 77,0 %, ce qui témoigne d'un progrès notable par rapport aux versions antérieures.

Science au niveau du doctorat : Sur les questions de biologie, de chimie et de physique de niveau doctoral, avec un faible effort de raisonnement, OpenAI o3-mini atteint des performances supérieures à OpenAI o1-mini. Avec un effort important, o3-mini atteint des performances comparables à celles de o1.

FrontierMath

Une grille noire avec plusieurs lignes et colonnes, séparées par de fines lignes blanches, créant une mise en page structurée et organisée.

Mathématiques de niveau recherche : L'OpenAI o3-mini avec un raisonnement élevé obtient de meilleurs résultats que son prédécesseur sur FrontierMath. Sur FrontierMath, lorsqu'il est invité à utiliser un outil Python, o3-mini with high reasoning effort résout plus de 32 % des problèmes du premier coup, dont plus de 28 % des problèmes difficiles (T3). Ces chiffres sont provisoires, et le graphique ci-dessus montre les performances sans outils ni calculatrice.

Code de la compétition (Codeforces)

Le diagramme à barres compare les notes Elo sur les tâches de codage de compétition Codeforces entre les modèles d'IA. Les anciens modèles (en gris) obtiennent de moins bons résultats, tandis que les nouveaux (en jaune) s'améliorent. "o3-mini (high)" atteint 2073 Elo, ce qui témoigne d'une progression significative par rapport aux versions précédentes.

Codage de compétition : Sur la programmation compétitive Codeforces, OpenAI o3-mini atteint des scores Elo progressivement plus élevés avec un effort de raisonnement accru, surpassant tous o1-mini. Avec un effort de raisonnement moyen, il égale les performances de o1.

Génie logiciel (SWE-bench vérifié)

Le diagramme à barres compare la précision des modèles d'IA sur les tâches de génie logiciel vérifiées par SWE-bench. Les modèles plus anciens (en gris) sont moins performants, tandis que "o3-mini (high)" (en jaune) obtient la plus grande précision (jaune) atteint la plus grande précision avec 48,9 %, ce qui témoigne d'une amélioration par rapport aux versions précédentes.

Génie logiciel : o3-mini est notre modèle publié le plus performant sur SWEbench-verified. Pour des données supplémentaires sur les résultats de SWE-bench Verified avec un effort de raisonnement élevé, y compris avec l'échafaudage Agentless open-source (39%) et un échafaudage d'outils internes (61%), consultez notre fiche système.

Codage LiveBench

Le tableau compare les modèles d'IA sur des tâches de codage, en montrant les mesures de performance et les scores d'évaluation. Il met en évidence les différences de précision et d'efficacité, certains modèles étant plus performants que d'autres dans des benchmarks spécifiques.

Codage LiveBench : OpenAI o3-mini surpasse o1-high même à un effort de raisonnement moyen, soulignant son efficacité dans les tâches de codage. À un effort de raisonnement élevé, o3-mini accroît encore son avance, obtenant des performances significativement plus élevées sur les mesures clés.

Connaissances générales

Le tableau intitulé "Évaluations par catégorie" compare les modèles d'IA dans différentes catégories d'évaluation, en indiquant les mesures de performance. Il met en évidence les différences de précision, d'efficacité et d'efficience, certains modèles étant plus performants que d'autres dans des tâches spécifiques.

Connaissances générales : o3-mini surpasse o1-mini dans les évaluations de connaissances dans les domaines de connaissances générales.

Évaluation des préférences humaines

Le graphique compare les taux de réussite des modèles d'IA pour les tâches STEM et non STEM. "o3_mini_v43_s960_j128" (jaune) surpasse "o1_mini_chatgpt" (ligne de base rouge) dans les deux catégories, avec un taux de victoire plus élevé pour les tâches STEM.

Le graphique compare les taux de victoire sous contrainte de temps et les taux d'erreurs majeures entre les modèles d'IA. "o3_mini_v43_s960_j128" (jaune) surpasse "o1_mini_chatgpt" (ligne de base rouge) en termes de taux de victoire et réduit de manière significative les erreurs majeures.

Évaluation des préférences humaines : Les évaluations réalisées par des testeurs experts externes montrent également que l'OpenAI o3-mini produit des réponses plus précises et plus claires, avec des capacités de raisonnement plus fortes que l'OpenAI o1-mini, en particulier pour les STEM. Les testeurs ont préféré les réponses de o3-mini à celles de o1-mini dans 56 % des cas et ont observé une réduction de 39 % des erreurs majeures sur des questions difficiles du monde réel.

Vitesse et performance du modèle

Avec une intelligence comparable à celle d'OpenAI o1, OpenAI o3-mini offre des performances plus rapides et une efficacité accrue. Au-delà des évaluations STEM soulignées ci-dessus, o3-mini démontre des résultats supérieurs dans des évaluations mathématiques et factuelles supplémentaires avec un effort de raisonnement moyen. Dans les tests A/B, o3-mini a fourni des réponses 24% plus rapidement que o1-mini, avec un temps de réponse moyen de 7,7 secondes contre 10,16 secondes.

Comparaison de la latence entre o1-mini et o3-mini (moyenne)

Le diagramme à barres compare le temps de latence entre les modèles "o1-mini" et "o3-mini (medium)". le modèle "o3-mini" (jaune plus clair) a un temps de latence plus faible, ce qui indique des temps de réponse plus rapides, tandis que le modèle "o1-mini" (jaune plus foncé) prend en moyenne plus de temps.

Latence : o3-mini a un temps moyen de 2500 ms plus rapide que o1-mini pour obtenir le premier jeton.

Sécurité

L'une des techniques clés que nous avons utilisées pour apprendre à l'OpenAI o3-mini à répondre en toute sécurité est l'alignement délibératif, où nous avons entraîné le modèle à raisonner sur les spécifications de sécurité écrites par l'homme avant de répondre aux invites de l'utilisateur. Comme pour l'OpenAI o1, nous constatons que l'OpenAI o3-mini surpasse de manière significative la GPT-4o dans les évaluations de sécurité et de jailbreak. Avant le déploiement, nous avons soigneusement évalué les risques de sécurité de o3-mini en utilisant la même approche de préparation, de red-teaming externe et d'évaluations de sécurité que o1. Nous remercions les testeurs de sécurité qui ont demandé à tester o3-mini en accès anticipé. Les détails des évaluations ci-dessous, ainsi qu'une explication complète des risques potentiels et de l'efficacité de nos mesures d'atténuation, sont disponibles dans la fiche du système o3-mini.

Évaluations du contenu interdit

Le tableau compare les modèles d'IA sur les mesures de sécurité, en évaluant les performances dans différentes catégories de risques. Il met en évidence les différences de conformité en matière de sécurité, certains modèles étant plus performants pour réduire les risques potentiels.

Évaluations du jailbreak

Le tableau compare les modèles d'IA sur les mesures de sécurité dans plusieurs catégories de risques, en montrant les variations de performance. Il met en évidence les différences en matière d'atténuation des risques, certains modèles se montrant plus respectueux des règles et plus sûrs dans leurs réponses.

Prochaines étapes

La sortie d'OpenAI o3-mini marque une nouvelle étape dans la mission d'OpenAI qui consiste à repousser les limites de l'intelligence rentable. En optimisant le raisonnement pour les domaines STEM tout en maintenant des coûts bas, nous rendons l'IA de haute qualité encore plus accessible. Ce modèle s'inscrit dans la continuité de notre politique de réduction du coût de l'intelligence - réduction du prix par jeton de 95 % depuis le lancement de GPT-4 - tout en conservant des capacités de raisonnement de premier plan. À mesure que l'adoption de l'IA se développe, nous nous engageons à rester à la pointe de la technologie en construisant des modèles qui concilient intelligence, efficacité et sécurité à grande échelle.

Auteurs

OpenAI

Formation

Brian Zhang, Eric Mitchell, Hongyu Ren, Kevin Lu, Max Schwarzer, Michelle Pokrass, Shengjia Zhao, Ted Sanders

Eval

Adam Kalai, Alex Tachard Passos, Ben Sokolowsky, Elaine Ya Le, Erik Ritter, Hao Sheng, Hanson Wang, Ilya Kostrikov, James Lee, Johannes Ferstad, Michael Lampe, Prashanth Radhakrishnan, Sean Fitzgerald, Sébastien Bubeck, Yann Dubois, Yu Bai

Évènements frontaliers et préparation

Andy Applebaum, Elizabeth Proehl, Evan Mays, Joel Parish, Kevin Liu, Leon Maksin, Leyton Ho, Miles Wang, Michele Wang, Olivia Watkins, Patrick Chao, Samuel Miserendino, Tejal Patwardhan

Ingénierie

Adam Walker, Akshay Nathan, Alyssa Huang, Andy Wang, Ankit Gohel, Ben Eggers, Brian Yu, Bryan Ashley, Chengdu Huang, Christian Hoareau, Davin Bogan, Emily Sokolova, Eric Horacek, Eric Jiang, Felipe Petroski Such, Jonah Cohen, Josh Gross, Justin Becker, Kan Wu, Kevin Whinnery, Larry Lv, Lee Byron, Manoli Liodakis, Max Johnson, Mike Trpcic, Murat Yesildal, Rasmus Rygaard, RJ Marsan, Rohit Ramchandani, Rohan Kshirsagar, Roman Huet, Sara Conlon, Shuaiqi (Tony) Xia, Siyuan Fu, Srinivas Narayanan, Sulman Choudhry, Tomer Kaftan, Trevor Creech

Recherche

Adam Fry, Adam Perelman, Brandon Wang, Cristina Scheau, Philip Pronin, Sundeep Tirumalareddy, Will Ellsworth, Zewei Chu

Produits

Antonia Woodford, Beth Hoover, Jake Brill, Kelly Stirman, Minnia Feng, Neel Ajjarapu, Nick Turley, Nikunj Handa, Olivier Godement

Sécurité

Andrea Vallone, Andrew Duberstein, Enis Sert, Eric Wallace, Grace Zhao, Irina Kofman, Jieqi Yu, Joaquin Quinonero Candela, Madelaine Boyd, Mehmet Yatbaz, Mike McClay, Mingxuan Wang, Saachi Jain, Sandhini Agarwal, Sam Toizer, Santiago Hernández, Steve Mostovoy, Young Cha, Tao Li, Yunyun Wang

Redteaming externe

Lama Ahmad, Troy Peterson

Gestionnaires du programme de recherche

Carpus Chang, Kristen Ying

Leadership

Aidan Clark, Dane Stuckey, Jerry Tworek, Jakub Pachocki, Johannes Heidecke, Kevin Weil, Liam Fedus, Mark Chen, Sam Altman, Wojciech Zaremba

+ tous les contributeurs de o1.

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs