OpenAI dévoile le GPT-4o mini, dont le prix est 25 fois inférieur à celui du GPT-4o, permettant à un plus grand nombre d'entreprises et d'utilisateurs d'accéder à une IA de qualité

OpenAI a dévoilé le GPT-4o mini, dont le prix est plus de 25 fois inférieur à celui du GPT-4o, qui figure en tête du classement, ce qui permet à un plus grand nombre d'entreprises et d'utilisateurs d'accéder à une IA de qualité. GPT-4o mini a été classé indépendamment sur parmi les 10 modèles d'IA les plus performants disponibles aujourd'hui modèles d'IA les plus performants disponibles aujourd'hui. Le GPT-4o mini obtient de bons résultats dans toute une série de tests de référence en matière d'IA, bien qu'il s'agisse d'un petit modèle LLM.

Un grand modèle linguistique (LLM) est créé après un entraînement sur des millions de documents et constitue la base d'un chatbot d'IA tel que ChatGPT. Le modèle contient ensuite des vecteurs mathématiques qui associent la probabilité d'apparition de mots, d'images et d'autres éléments. Par exemple, la probabilité que "ice" apparaisse à côté de "cream" est bien plus grande que celle qu'il apparaisse à côté de "stone". Cependant, un grand LLM utilise beaucoup de puissance de calcul https://arxiv.org/pdf/2210.17331 et d'énergie pour répondre aux demandes des utilisateurs, ce qui représente un coût élevé pour ces derniers. L'élagage des LLM peut les rendre plus petits, moins chers et plus respectueux de l'environnement, avec pour contrepartie des réponses moins précises.

Les lecteurs qui ne savent pas comment utiliser l'IA pour mieux accomplir des tâches commerciales ou pour gagner plus d'argent peuvent lire ce livre sur Amazon.

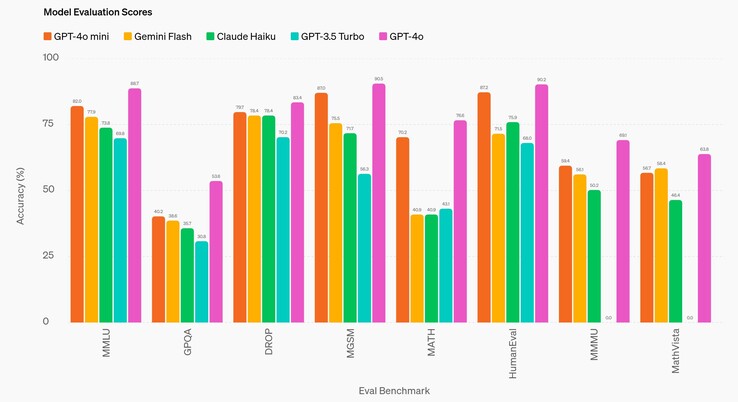

Dans une comparaison directe avec GPT-4ole meilleur LLM d'OpenAI publié en 2024, GPT-4o mini produit systématiquement des réponses moins précises. En comparaison avec le GPT-3.5 Turbo de 2022, GPT-4o mini est toujours plus performant. Sur une variété de tests d'IA de niveau universitaire (DROP, HumanEval, MATH, MathVistaMGSM, MMLUet MMMU), le modèle répond aux questions avec précision dans 60 à 80 % des cas. Ce n'est que pour le test de niveau doctoral (GPQA) que sa précision tombe à environ 40 %, soit à peine mieux qu'un non-expert cherchant une réponse en ligne.

Il est important de noter que le prix du GPT-4o est de 5 $/1M de jetons d'entrée et de 15 $/1M de jetons de sortie, tandis que le prix du GPT-4o mini est de 0,15 $/1M d'entrée et de 0,60 $/1M de sortie (1 000 jetons correspondent à environ 750 mots). Ce prix est inférieur à celui de environ quatre-vingts LLMcourants utilisés aujourd'hui, à l'exception de mistral-embed.

Le GPT-4o mini dispose d'une fenêtre contextuelle d'entrée de 128K tokens, ce qui correspond à la quantité de texte pouvant être analysée en une seule fois, de sorte que l'analyse de grands volumes de documents commerciaux et juridiques est limitée. La fenêtre de sortie est limitée à 16 000 jetons. Le modèle a également un seuil de connaissances fixé à octobre 2023, de sorte que les nouvelles, les événements et les découvertes qui se produisent après cette date sont inconnus de l'IA et ne peuvent pas être utilisés pour répondre aux questions.

Les lecteurs qui attendent toujours que les robots humanoïdes de l'IA soient honnêtes et cuisinent pour eux, comme le fait le prototype 1X Neodevront se contenter de robots non dotés d'IA(comme cet aspirateur sur Amazon) en attendant.

18 juillet 2024

GPT-4o mini : l'intelligence au service de la rentabilité

Présentation de notre petit modèle le plus rentable

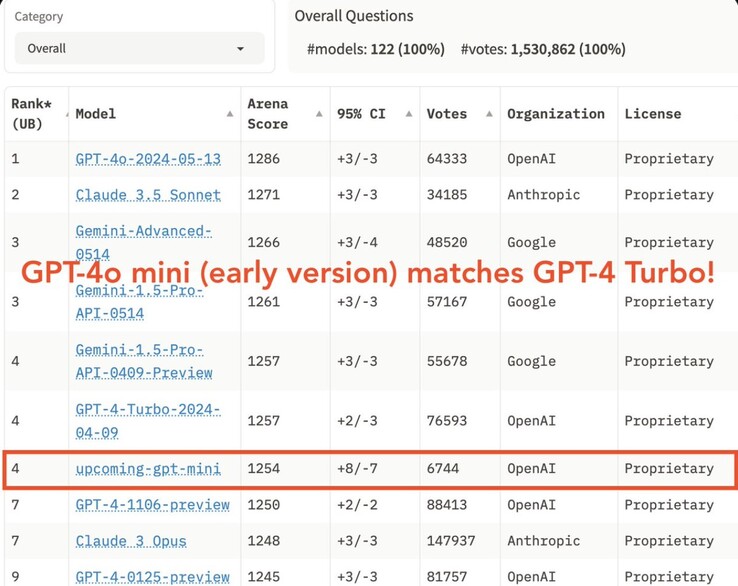

OpenAI s'engage à rendre l'intelligence aussi largement accessible que possible. Aujourd'hui, nous annonçons GPT-4o mini, notre petit modèle le plus rentable. Nous pensons que le GPT-4o mini élargira considérablement la gamme d'applications construites avec l'IA en rendant l'intelligence beaucoup plus abordable. GPT-4o mini obtient un score de 82 % sur MMLU et surpasse actuellement GPT-41 sur les préférences de chat dans le classement LMSYS (s'ouvre dans une nouvelle fenêtre). Son prix est de 15 cents par million de jetons d'entrée et de 60 cents par million de jetons de sortie, soit un ordre de grandeur plus abordable que les modèles frontières précédents et plus de 60 % moins cher que le GPT-3.5 Turbo.

GPT-4o mini permet de réaliser un large éventail de tâches grâce à son faible coût et à sa latence, comme les applications qui enchaînent ou parallélisent plusieurs appels de modèle (par exemple, l'appel de plusieurs API), transmettent un grand volume de contexte au modèle (par exemple, la base de code complète ou l'historique des conversations), ou interagissent avec les clients par le biais de réponses textuelles rapides et en temps réel (par exemple, les chatbots d'assistance à la clientèle).

Aujourd'hui, GPT-4o mini prend en charge le texte et la vision dans l'API, avec une prise en charge future des entrées et sorties texte, image, vidéo et audio. Le modèle dispose d'une fenêtre contextuelle de 128 000 jetons, prend en charge jusqu'à 16 000 jetons de sortie par demande et dispose de connaissances jusqu'en octobre 2023. Grâce au tokenizer amélioré partagé avec GPT-4o, le traitement de textes non anglais est désormais encore plus rentable.

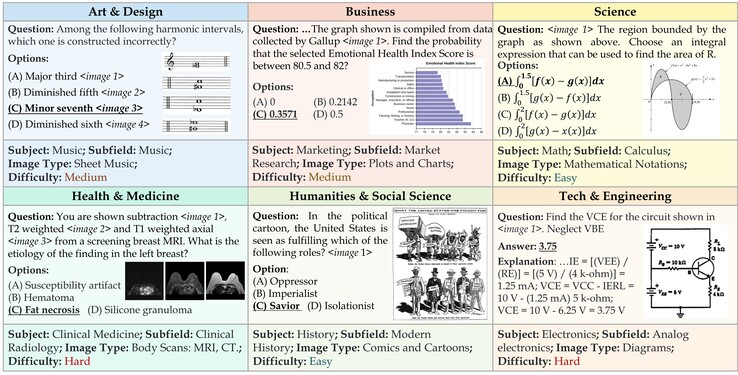

Un petit modèle doté d'une intelligence textuelle et d'un raisonnement multimodal supérieurs

GPT-4o mini surpasse GPT-3.5 Turbo et d'autres petits modèles sur des benchmarks académiques en termes d'intelligence textuelle et de raisonnement multimodal, et prend en charge la même gamme de langues que GPT-4o. Il affiche également de bonnes performances en matière d'appel de fonctions, ce qui permet aux développeurs de créer des applications qui récupèrent des données ou entreprennent des actions avec des systèmes externes, ainsi que des performances améliorées en matière de contexte long par rapport à GPT-3.5 Turbo.

GPT-4o mini a été évalué sur plusieurs points de référence clés2.

Tâches de raisonnement : GPT-4o mini est meilleur que d'autres petits modèles pour les tâches de raisonnement impliquant à la fois du texte et de la vision, obtenant un score de 82,0 % sur MMLU, une référence en matière d'intelligence textuelle et de raisonnement, contre 77,9 % pour Gemini Flash et 73,8 % pour Claude Haiku.

Compétence en mathématiques et en codage : Le GPT-4o mini excelle dans les tâches de raisonnement mathématique et de codage, surpassant les petits modèles précédents sur le marché. Au MGSM, qui mesure le raisonnement mathématique, GPT-4o mini a obtenu un score de 87,0 %, contre 75,5 % pour Gemini Flash et 71,7 % pour Claude Haiku. GPT-4o mini a obtenu un score de 87,2 % sur HumanEval, qui mesure les performances de codage, contre 71,5 % pour Gemini Flash et 75,9 % pour Claude Haiku.

Raisonnement multimodal : GPT-4o mini montre également de bonnes performances sur MMMU, une évaluation du raisonnement multimodal, avec un score de 59,4% comparé à 56,1% pour Gemini Flash et 50,2% pour Claude Haiku.

Dans le cadre du processus de développement de notre modèle, nous avons travaillé avec une poignée de partenaires de confiance pour mieux comprendre les cas d'utilisation et les limites de GPT-4o mini. Nous nous sommes associés à des entreprises telles que Ramp(s'ouvre dans une nouvelle fenêtre) et Superhuman(s'ouvre dans une nouvelle fenêtre) qui ont constaté que GPT-4o mini était nettement plus performant que GPT-3.5 Turbo pour des tâches telles que l'extraction de données structurées à partir de fichiers de réception ou la génération de réponses de haute qualité à des courriels lorsque l'on dispose de l'historique des discussions.

Mesures de sécurité intégrées

La sécurité est intégrée à nos modèles dès le départ et renforcée à chaque étape de notre processus de développement. Lors du pré-entraînement, nous filtrons les informations dont nous ne voulons pas que nos modèles tirent des enseignements ou produisent des résultats, comme les discours haineux, les contenus pour adultes, les sites qui regroupent principalement des informations personnelles et les spams. En post-formation, nous alignons le comportement du modèle sur nos politiques en utilisant des techniques telles que l'apprentissage par renforcement avec retour d'information humain (RLHF) afin d'améliorer la précision et la fiabilité des réponses du modèle.

Le GPT-4o mini intègre les mêmes mesures d'atténuation de la sécurité que le GPT-4o, que nous avons soigneusement évaluées à l'aide d'évaluations automatisées et humaines, conformément à notre cadre de préparation et à nos engagements volontaires. Plus de 70 experts externes dans des domaines tels que la psychologie sociale et la désinformation ont testé le GPT-4o afin d'identifier les risques potentiels, que nous avons traités et dont nous prévoyons de partager les détails dans la prochaine carte du système GPT-4o et le tableau de bord de la préparation. Les enseignements tirés de ces évaluations d'experts ont permis d'améliorer la sécurité du GPT-4o et du GPT-4o mini.

Sur la base de ces enseignements, nos équipes ont également travaillé à l'amélioration de la sécurité du GPT-4o mini en utilisant de nouvelles techniques issues de nos recherches. GPT-4o mini dans l'API est le premier modèle à appliquer notre méthode de hiérarchie des instructions(s'ouvre dans une nouvelle fenêtre), qui permet d'améliorer la capacité du modèle à résister aux jailbreaks, aux injections d'invites et aux extractions d'invites système. Les réponses du modèle sont ainsi plus fiables et son utilisation dans des applications à grande échelle est plus sûre.

Nous continuerons à surveiller l'utilisation de GPT-4o mini et à améliorer la sécurité du modèle au fur et à mesure que nous identifierons de nouveaux risques.

Disponibilité et prix

GPT-4o mini est désormais disponible en tant que modèle de texte et de vision dans l'API Assistants, l'API Chat Completions et l'API Batch. Les développeurs paient 15 cents pour 1M de jetons d'entrée et 60 cents pour 1M de jetons de sortie (à peu près l'équivalent de 2500 pages dans un livre standard). Nous prévoyons de procéder à des ajustements pour GPT-4o mini dans les prochains jours.

Dans ChatGPT, les utilisateurs Free, Plus et Team pourront accéder à GPT-4o mini à partir d'aujourd'hui, à la place de GPT-3.5. Les utilisateurs de l'entreprise y auront également accès à partir de la semaine prochaine, conformément à notre mission de rendre les avantages de l'IA accessibles à tous.

Prochaines étapes

Au cours des dernières années, nous avons assisté à des avancées remarquables en matière d'intelligence artificielle, associées à des réductions substantielles des coûts. Par exemple, le coût par jeton de GPT-4o mini a chuté de 99 % depuis text-davinci-003, un modèle moins performant introduit en 2022. Nous nous engageons à poursuivre cette trajectoire de réduction des coûts tout en améliorant les capacités des modèles.

Nous envisageons un avenir où les modèles seront intégrés de manière transparente dans toutes les applications et sur tous les sites web. GPT-4o mini ouvre la voie aux développeurs pour qu'ils puissent créer et mettre à l'échelle de puissantes applications d'IA de manière plus efficace et plus abordable. L'avenir de l'IA devient plus accessible, plus fiable et plus intégré dans nos expériences numériques quotidiennes, et nous sommes ravis de continuer à ouvrir la voie.

Auteur

OpenAI

Remerciements

Responsables : Jacob Menick, Kevin Lu, Shengjia Zhao, Eric Wallace, Hongyu Ren, Haitang Hu, Nick Stathas, Felipe Petroski Such

Responsable du programme : Mianna Chen

Contributions notées sur openai.com/gpt-4o-contributions/

Notes de bas de page

1

À partir du 18 juillet 2024, une version antérieure de GPT-4o mini surpasse GPT-4T 01-25.

2

Les nombres d'évaluation pour GPT-4o mini sont calculés en utilisant notre repo simple-evals(s'ouvre dans une nouvelle fenêtre) avec l'invite de message du système de l'assistant API. Pour les modèles concurrents, nous prenons le nombre maximum sur leur nombre rapporté (si disponible), le classement HELM(opens in a new window), et notre propre reproduction via simple-evals.

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs