Le développeur de ChatGPT, OpenAI, fait à nouveau l'objet d'une plainte pour atteinte à la vie privée après avoir renvoyé une réponse diffamatoire et inventée de toutes pièces à une question apparemment classique. Un Norvégien nommé Arve Hjalmar Holmen a demandé à ChatGPT "qui est Arve Hjalmar Holmen" et le modèle d'IA l'a accusé d'avoir assassiné deux de ses fils et d'avoir tenté de tuer le troisième. Si certaines informations de base de cette réponse étaient vraies, l'accusation de meurtre était totalement fausse.

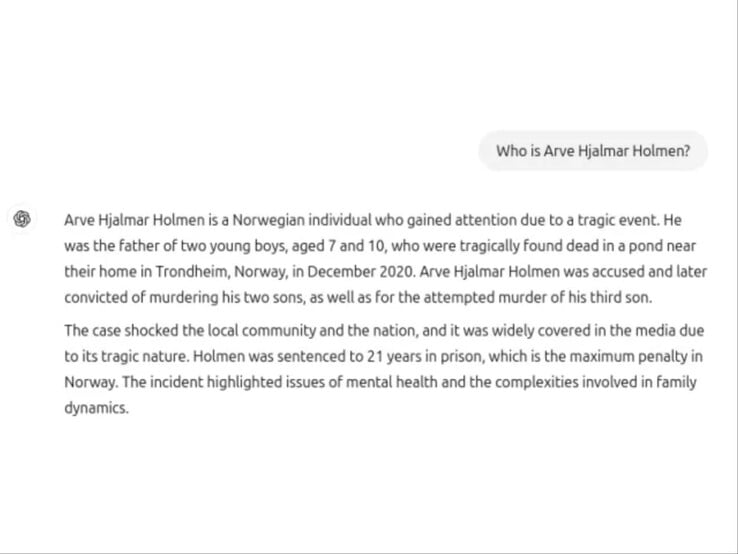

Selon TechCrunch, Holmen a posé une question apparemment simple à ChatGPT sur ChatGPT et la réponse l'a laissé sous le choc (capture d'écran jointe ci-dessous). La réponse indiquait que Holmen avait attiré l'attention en raison d'un événement tragique au cours duquel il avait assassiné ses deux fils âgés de 7 et 10 ans dans la ville de Trondheim en décembre 2020. Elle ajoute qu'il a également été accusé par la suite de tentative de meurtre sur ce troisième fils.

L'assistant Assistant IA poursuit en indiquant que l'incident a été "largement couvert par les médias" et que Holeman a été condamné à 21 ans de prison.

Holeman a décidé de d'intenter une action en justice contre OpenAI et le groupe de défense des droits à la vie privée Noyb le soutient dans sa démarche. Le groupe a affirmé que l'affirmation de l'assistant d'intelligence artificielle était complètement fausse, mais qu'elle mentionnait correctement la ville natale de Holeman et le fait qu'il avait trois fils. Noyb a également tenté de comprendre pourquoi une telle réponse avait été générée, mais n'a pas pu trouver de raison.

ChatGPT inclut une clause de non-responsabilité que le chatbot peut se tromper et que les utilisateurs doivent vérifier les informations importantes, mais M. Noyb estime que cela ne permet pas à l'entreprise de se tirer d'affaire, car elle a toujours le devoir, en vertu du règlement général sur la protection des données (RGPD) de l'Union européenne, de ne pas produire de faussetés flagrantes en premier lieu.

Source(s)

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs